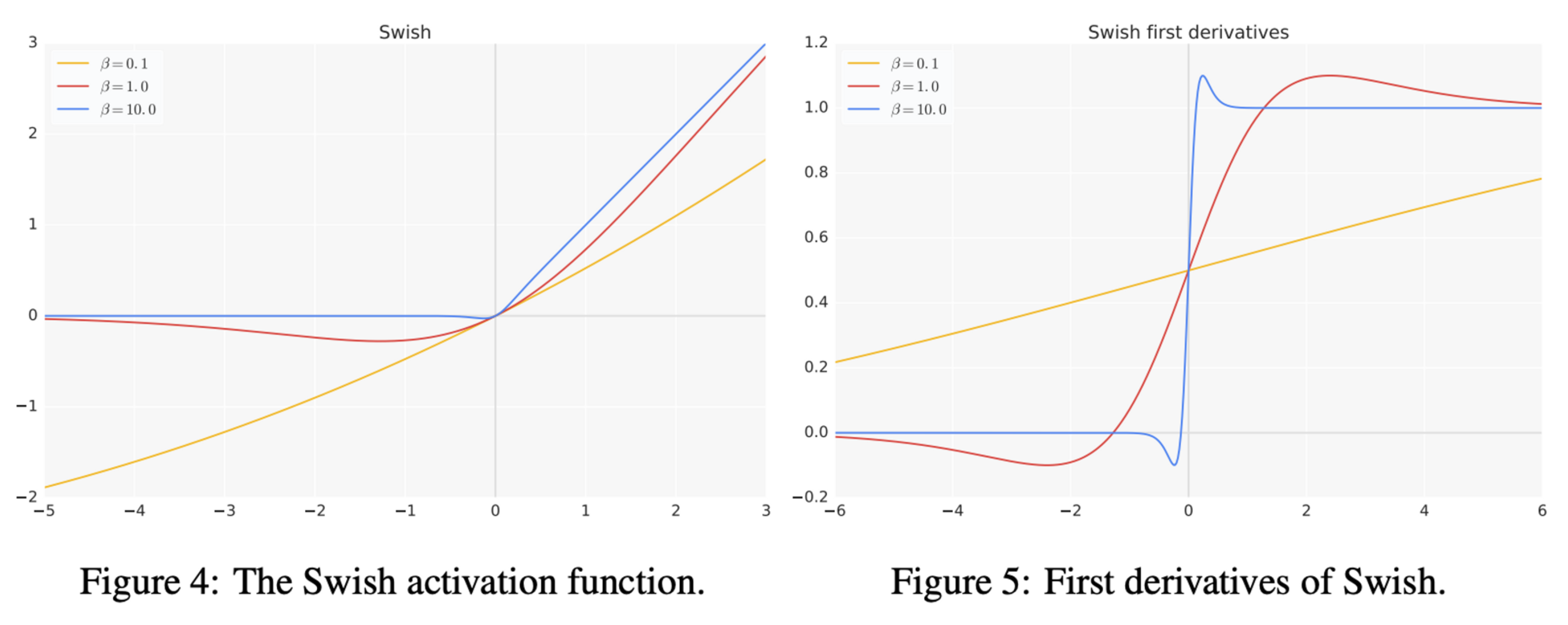

Transformers 아키텍처에서 자주 사용되는 SwiGLU activation function 은 어떤 함수일까? 이를 이해하기 위해 Swish, GLU, SwiGLU 를 차례대로 이해할 필요가 있다. 결론만 먼저 얘기하면 아래와 같다.📌 SummarySwish: β 값에 따라 다른 특성을 가질 수 있는 activation function 의 한 종류이다.GLU: Component-wise product of two linear transformations of inputSwiGLU: Swish 를 non-linear function 으로 사용하고, GLU 를 적용한 activation function 이다.1. Swish1.1 Swish 의 특징Searching for Activatio..